Polícia britânica suspende tecnologia de reconhecimento facial após dezenas de erros

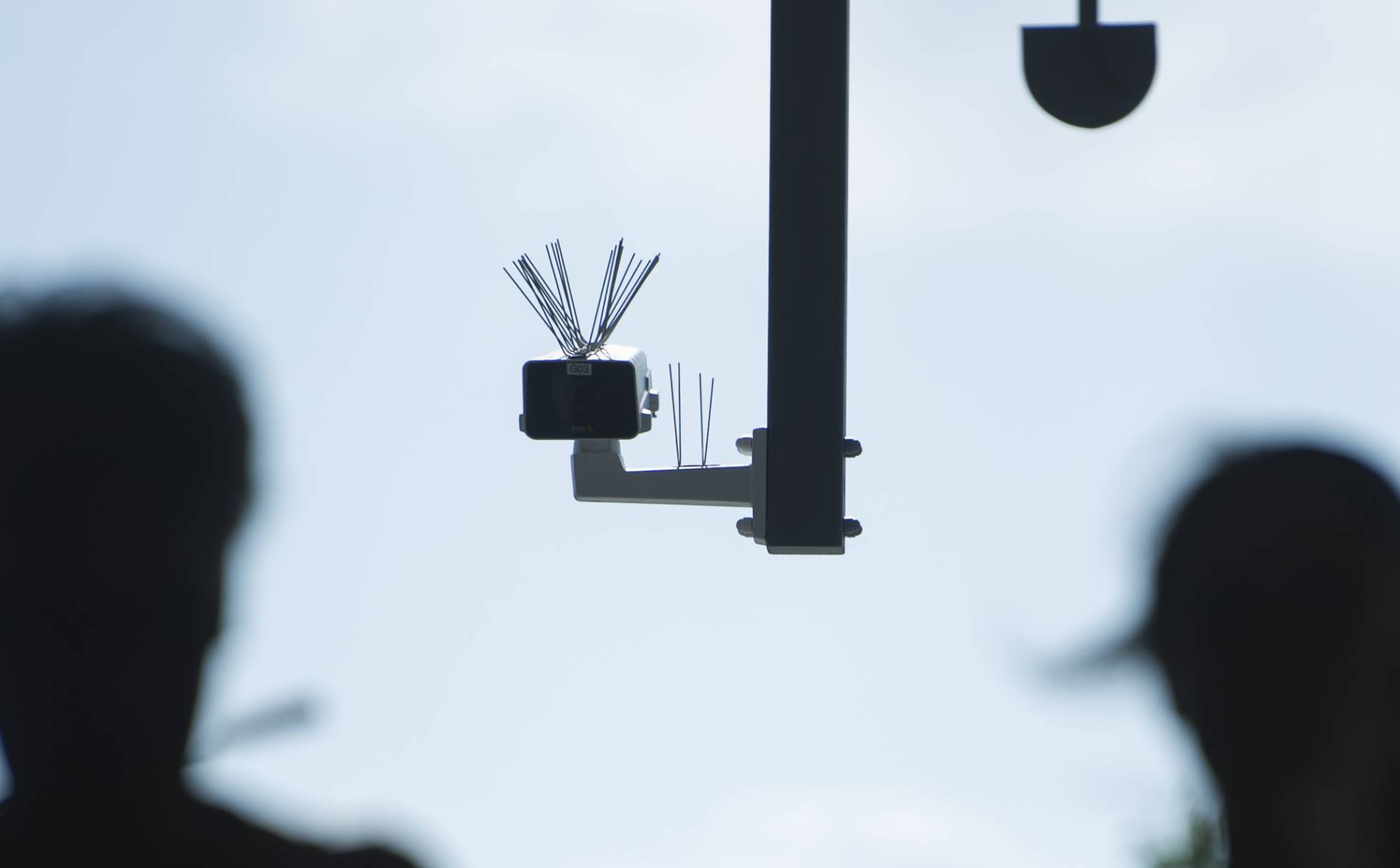

A Polícia da Grande Manchester (GMP) se viu forçada a suspender um polêmico programa de vigilância secreta, que monitorava todos os visitantes do distrito comercial de Trafford, visitado por cerca de 30 milhões de pessoas anualmente.

Alguém pode tirar sua foto na rua e conseguir saber quem você é para contatá-lo. Acontece na Rússia. Alguém pode atravessar a faixa de pedestres quando não for permitido e ver que as autoridades lhe multam e pegam sua foto atravessando indevidamente nas paradas de ônibus após identificá-lo com a imagem captada por uma câmera de segurança. Acontece na China. Uma pessoa pode receber a visita inoportuna da polícia porque o algoritmo falhou e a identificou erroneamente. Aconteceu nos Estados Unidos, em cinco ocasiões, com cinco pessoas, em 2015, como admitiu a polícia de Nova York.

A GMP utilizou a tecnologia AFR (Automatic Facial Recognition — Reconhecimento Facial Automático) para fazer a varredura dos compradores na área por um período de seis meses, analisando e armazenando as imagens de potencialmente milhões sem nenhum termo de confidencialidade ou consentimento por aqueles secretamente vigiados.

Quando implantada no Carnaval de Notting Hill de 2017, por exemplo, a tecnologia produziu uma identificação precisa e 95 “falsos positivos”. De forma ainda mais contundente, os dois indivíduos que foram identificados corretamente pelos sistemas da AP de Met desde 2016 não eram criminosos — um deles havia sido colocado em uma lista de vigilância interna por engano, e o outro estava relacionado à lista de saúde mental, que compila quem poderia ser um risco para si ou para os outros. Apesar desta história menos que ilustre, a força pretende operar sistemas AFR em vários outros grandes eventos no futuro.

A experiência da AFR pela Polícia de South Wales é apenas um pouco menos lamentável, com seus sistemas produzindo falsos positivos em 91% dos casos.

Um estudo do Instituto de Tecnologia de Massachusetts (MIT) sobre o uso comercial de sistemas de inteligência artificial descobriu que a taxa de erro do software de reconhecimento facial era 43 vezes maior para mulheres de pele escura do que para homens de pele clara.

Fontes: Sputnik Brasil, El País